Các mô hình AI mới của OpenAI giờ đây có thể chạy trực tiếp trên GPU NVIDIA, mở ra kỷ nguyên AI thời gian thực.

AI dịch chuyển từ đám mây xuống máy cá nhân

Sự kết hợp giữa các mô hình AI mới của OpenAI và phần cứng GPU NVIDIA đang thúc đẩy làn sóng ứng dụng trí tuệ nhân tạo ngay trên máy cá nhân. Trong nhiều năm, các mô hình AI lớn thường chỉ hoạt động hiệu quả khi được triển khai trên hạ tầng đám mây, nhờ sức mạnh tính toán tập trung từ các cụm máy chủ với GPU chuyên dụng. NVIDIA H100 là ví dụ tiêu biểu, một GPU data center mạnh mẽ bậc nhất thường xuất hiện trong các trung tâm dữ liệu để vận hành các mô hình AI khổng lồ như gpt-oss-120b hay gpt-oss-20b.

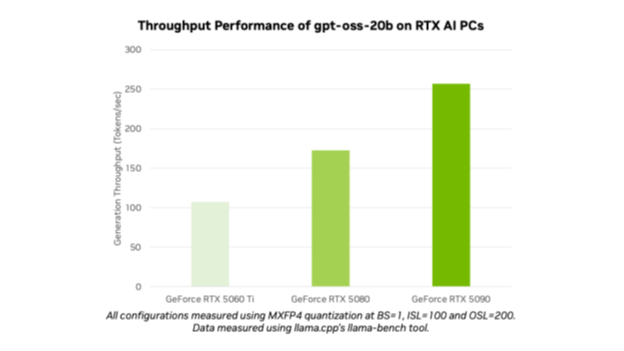

Cùng với sự phát triển của phần cứng tiêu dùng cao cấp như RTX 5090, khoảng cách giữa khả năng xử lý của cloud và local đang thu hẹp nhanh chóng. Điều này mở ra khả năng đưa AI xuống thẳng máy cá nhân, giúp người dùng tận hưởng tốc độ phản hồi gần như tức thì, giảm phụ thuộc vào đường truyền internet và tăng tính bảo mật dữ liệu.

Sức mạnh từ các mô hình AI mới

OpenAI đã mở rộng hỗ trợ trên nhiều nền tảng phần cứng, với các mô hình đáng chú ý gồm GPT-4o mini – phiên bản gọn nhẹ tối ưu tốc độ và tài nguyên; gpt-oss-20b – mô hình mã nguồn mở dung lượng 20 tỷ tham số; gpt-oss-120b – mô hình mã nguồn mở cực lớn, trước đây chủ yếu chạy trên hạ tầng H100; cùng các mô hình đa phương tiện như text-to-speech và text-to-image. Nhờ tối ưu hóa phần mềm và kiến trúc phần cứng, các mô hình này không chỉ chạy tốt trên H100 mà còn vận hành hiệu quả trên GPU RTX, đặc biệt là RTX 5090 và các phiên bản RTX 40 Series cao cấp.

Kiến trúc phần cứng cho AI thời gian thực

Điểm chung giữa H100 và RTX 5090 là đều được xây dựng trên kiến trúc GPU tiên tiến của NVIDIA, với nhân Tensor Core chuyên xử lý AI, băng thông bộ nhớ cao và khả năng xử lý song song hàng nghìn luồng dữ liệu. H100 tập trung vào xử lý AI quy mô lớn, đào tạo và suy luận với hàng trăm tỷ tham số. RTX 5090, dù là GPU tiêu dùng, vẫn đủ sức vận hành các mô hình AI cỡ vừa và lớn trong thời gian thực, từ trợ lý hội thoại, tạo hình ảnh chất lượng cao đến phân tích dữ liệu cục bộ. Việc gpt-oss-120b có thể chạy ở chế độ suy luận tối ưu trên RTX 5090 minh chứng cho xu hướng thu hẹp khoảng cách giữa AI cloud và AI local.

Ollama – Cầu nối đưa AI về máy người dùng

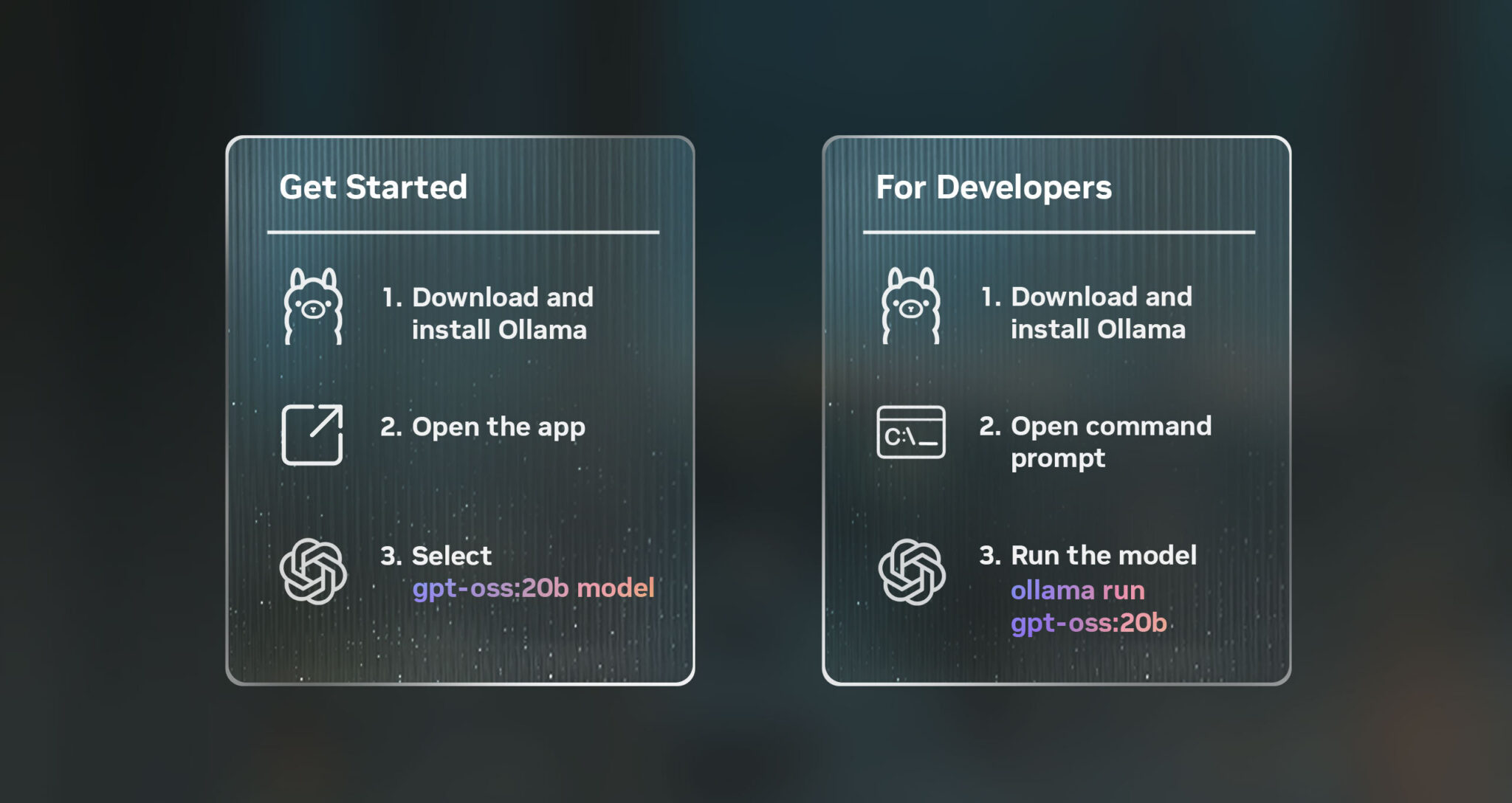

Ollama là nền tảng mã nguồn mở cho phép cài đặt và vận hành các mô hình AI trực tiếp trên máy tính cá nhân. Nền tảng này hỗ trợ sẵn nhiều model như GPT-4o mini, gpt-oss-20b và gpt-oss-120b, đồng thời tối ưu hóa hiệu năng khi chạy trên GPU NVIDIA RTX. Nhờ Ollama, nhà phát triển và người dùng có thể khởi động môi trường AI nhanh chóng, tải model mong muốn và bắt đầu sử dụng mà không cần cấu hình phức tạp. Khi kết hợp với sức mạnh của RTX 5090 hoặc các GPU RTX cao cấp khác, thời gian suy luận được rút ngắn, phản hồi mượt mà và dữ liệu được xử lý offline để đảm bảo bảo mật.

Tác động tới ngành nghề và xu hướng tương lai

Việc đưa AI xuống chạy trực tiếp trên GPU cá nhân tạo ra thay đổi lớn trong quy trình làm việc ở nhiều lĩnh vực. Ngành sáng tạo nội dung có thể dựng video, tạo hình ảnh hoặc lồng tiếng ngay lập tức. Các nhóm nghiên cứu khoa học phân tích dữ liệu lớn tại chỗ mà không cần thuê hạ tầng đắt đỏ. Dịch vụ khách hàng hưởng lợi từ trợ lý ảo xử lý yêu cầu tức thì, trong khi giáo dục có thể triển khai công cụ giảng dạy tương tác ở nơi internet hạn chế.

Sự hợp tác giữa OpenAI và NVIDIA không chỉ mang lại bước tiến về tốc độ và hiệu quả xử lý AI mà còn đặt nền móng cho thế hệ ứng dụng tiếp theo. Khi kết hợp huấn luyện mô hình trên H100 và triển khai trên RTX 5090 qua nền tảng như Ollama, AI không còn giới hạn ở trung tâm dữ liệu mà đang trở thành công cụ cá nhân hóa, mạnh mẽ và luôn sẵn sàng ngay trên bàn làm việc.