Huawei hiện được cho là đang phát triển một loại bộ nhớ chuyên dụng cho các tác vụ AI, được kỳ vọng có thể thay thế HBM với dung lượng hiệu quả và hiệu suất cao.

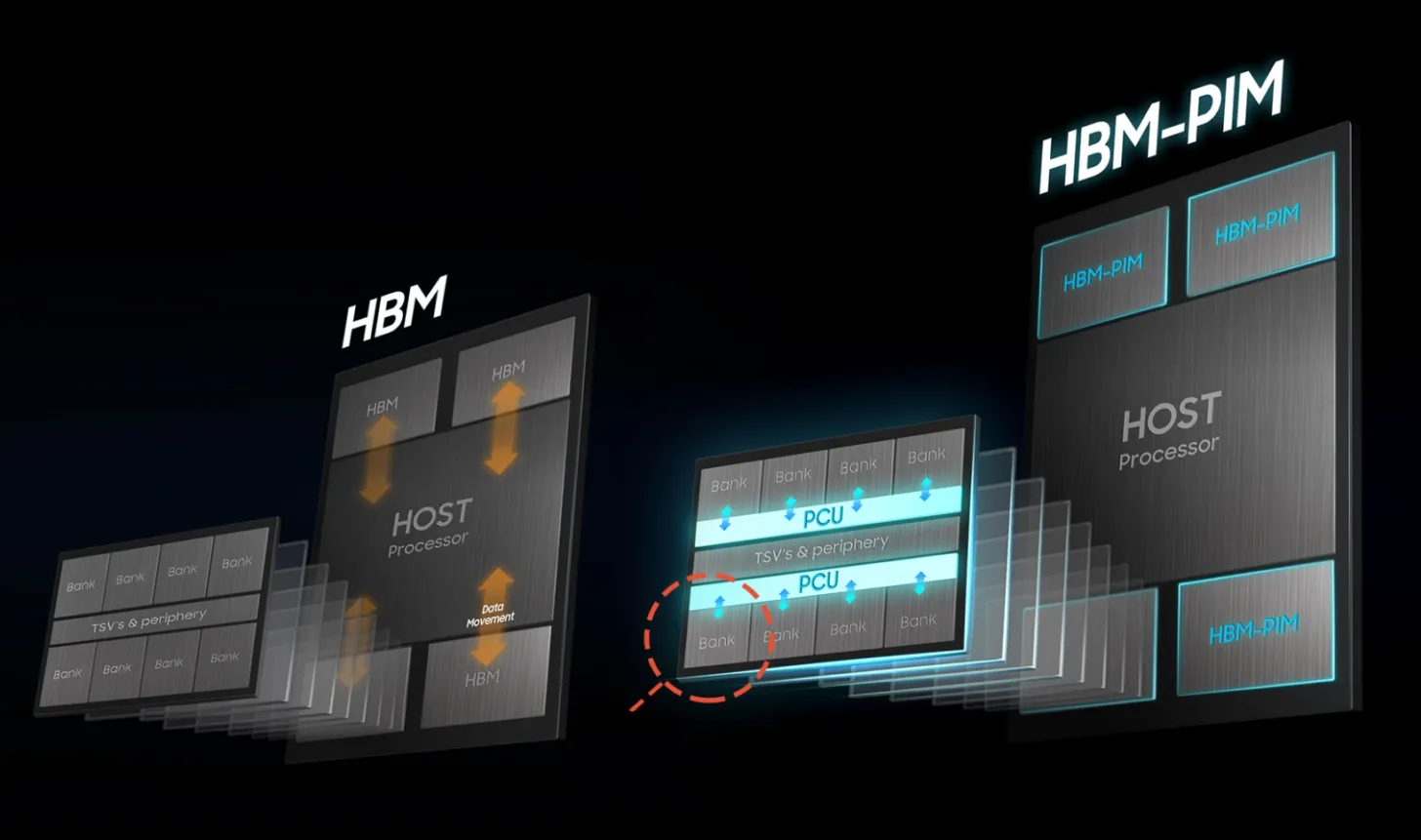

Trong bức tranh phát triển phần cứng AI của Trung Quốc, rào cản lớn nằm ở việc thiếu các giải pháp bộ nhớ băng thông cao (HBM) đủ năng lực. Một số công ty như CXMT đã đạt được những bước tiến nhất định, nhưng nhìn chung vẫn còn khoảng cách so với công nghệ bộ nhớ đến từ phương Tây. Theo các nguồn tin truyền thông Trung Quốc, Huawei hiện đang phát triển một giải pháp bộ nhớ AI chuyên dụng, được cho là dạng ổ cứng thể rắn (SSD) nhưng được tinh chỉnh đặc biệt cho trung tâm dữ liệu.

Dù các thông số kỹ thuật cụ thể chưa được công bố, bước tiến này được cho là có thể giúp ngành công nghiệp trong nước bớt phụ thuộc vào HBM, vốn đang bị hạn chế mạnh mẽ do yếu tố địa chính trị. Báo cáo cho biết, AI SSD của Huawei sẽ không bị giới hạn dung lượng và có khả năng tăng đáng kể sức mạnh tính toán. Tuy nhiên, việc ứng dụng thực tế vẫn chưa được tiết lộ, nên những tuyên bố này vẫn cần được xem xét thận trọng.

Trong lĩnh vực lưu trữ bộ nhớ AI, Huawei trước đó cũng đã giới thiệu bộ phần mềm UCM (Unified Cache Manager), cho phép tăng tốc huấn luyện LLM bằng cách phối hợp giữa HBM, DRAM thông thường và SSD.

Nhờ vậy, hãng có thể mở rộng khả năng sử dụng bộ nhớ cho các tác vụ AI mà không cần ngay lập tức sở hữu phần cứng tiên tiến – một hướng đi được xem là giải pháp tạm thời trước hạn chế về HBM. Điều này cho thấy Huawei đã và đang nỗ lực tìm lối thoát trong bối cảnh nhiều giới hạn áp đặt lên công ty, và một AI SSD có vẻ đang trở thành mục tiêu tiếp theo.

Trong mảng phần cứng AI, Huawei cũng liên tục mở rộng năng lực, cả ở khía cạnh suy luận (inferencing) lẫn huấn luyện (training), cho thấy họ đang có một tốc độ phát triển rất nhanh.

Nguồn: wccftech