Tại OCP Global Summit, NVIDIA đã giới thiệu các thành phần của hệ thống NVIDIA GB200 NVL72 cho cộng đồng OCP. Thiết kế này bao gồm kiến trúc rack, khay máy tính và công tắc, cùng các đặc điểm về làm mát bằng chất lỏng và môi trường nhiệt. Mục tiêu là giúp tăng mật độ tính toán và băng thông mạng cho các trung tâm dữ liệu.

NVIDIA đã từng đóng góp nhiều thế hệ phần cứng khác nhau cho OCP, từ thiết kế NVIDIA HGX H100 cho đến việc mở rộng nền tảng Ethernet Spectrum-X. Những đóng góp này nhằm giúp các nhà sản xuất máy tính trên thế giới có nhiều lựa chọn hơn và thúc đẩy việc áp dụng trí tuệ nhân tạo (AI).

Với sự hỗ trợ từ các tiêu chuẩn do OCP phát triển, các doanh nghiệp có thể tối ưu hóa hiệu năng của hạ tầng AI mà vẫn duy trì được tính nhất quán của phần mềm. Jensen Huang, nhà sáng lập và CEO của NVIDIA, cho biết: “Chúng tôi đang hợp tác với các nhà lãnh đạo trong ngành để định hình những tiêu chuẩn có thể được áp dụng rộng rãi cho toàn bộ trung tâm dữ liệu, giúp các tổ chức khai thác tiềm năng của tính toán tăng tốc và xây dựng các nhà máy AI tương lai.”

Nền tảng tính toán tăng tốc cho cuộc cách mạng công nghiệp tiếp theo

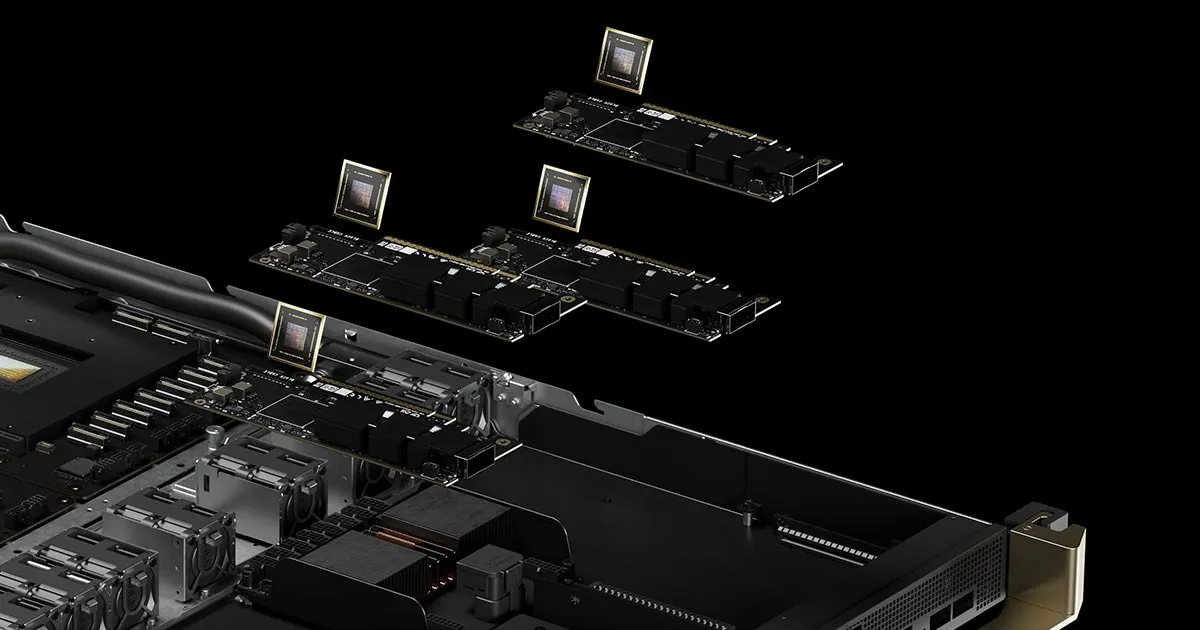

Nền tảng tính toán Blackwell của NVIDIA được thiết kế để hỗ trợ sự phát triển của AI. Hệ thống GB200 NVL72 dựa trên kiến trúc mô-đun NVIDIA MGX, giúp các nhà sản xuất máy tính dễ dàng phát triển các thiết kế hạ tầng trung tâm dữ liệu.

Hệ thống làm mát bằng chất lỏng của NVIDIA kết nối 36 CPU Grace và 72 GPU Blackwell trong một thiết kế quy mô rack. Với 72 GPU kết nối thông qua NVLink, hệ thống này hoạt động như một GPU khổng lồ, cung cấp khả năng suy luận mô hình ngôn ngữ lớn nhanh hơn 30 lần so với GPU H100.

Nền tảng mạng Spectrum-X, bao gồm cả thế hệ NVIDIA ConnectX-8 SuperNIC mới, hỗ trợ các tiêu chuẩn OCP như Switch Abstraction Interface (SAI) và Software for Open Networking in the Cloud (SONiC). Điều này giúp tăng tốc độ mạng Ethernet với khả năng định tuyến thích ứng và kiểm soát tắc nghẽn dựa trên phân tích từ xa, phục vụ cho các khối lượng công việc AI quy mô lớn.

ConnectX-8 SuperNIC cung cấp khả năng kết nối mạng lên đến 800Gb/s, cùng với khả năng xử lý gói tin được tối ưu hóa cho các tác vụ AI khổng lồ. Dòng sản phẩm này sẽ được cung cấp từ năm sau, hỗ trợ các tổ chức xây dựng mạng lưới linh hoạt hơn.

Hạ tầng quan trọng cho trung tâm dữ liệu

Khi thế giới chuyển từ tính toán đa mục đích sang tính toán tăng tốc và AI, hạ tầng trung tâm dữ liệu ngày càng phức tạp. NVIDIA đang hợp tác với hơn 40 nhà sản xuất điện tử trên toàn cầu để đơn giản hóa quá trình phát triển hạ tầng AI.

Ngoài ra, một loạt đối tác cũng đang đổi mới và xây dựng trên nền tảng Blackwell, bao gồm Meta. Công ty này dự định đóng góp kiến trúc rack Catalina AI dựa trên hệ thống GB200 NVL72 vào OCP, cung cấp cho các nhà sản xuất máy tính thêm nhiều tùy chọn để phát triển hệ thống với mật độ tính toán cao và đáp ứng nhu cầu ngày càng lớn về hiệu suất và hiệu quả năng lượng.

Phó chủ tịch kỹ thuật của Meta, Yee Jiun Song, khẳng định: “Các đóng góp của NVIDIA cho các tiêu chuẩn điện toán mở đã giúp thúc đẩy sự phát triển của hạ tầng AI, và những cải tiến mới nhất trong thiết kế rack và kiến trúc mô-đun sẽ đẩy nhanh quá trình triển khai AI trong toàn ngành.”

NVIDIA sẽ tiếp tục chia sẻ thêm về những đóng góp của mình tại OCP Global Summit 2024, tổ chức tại San Jose từ ngày 15-17 tháng 10.