Một báo cáo học thuật năm 2017 từ Google Brain đã đặt nền móng cho các mô hình AI tạo sinh hiện đại, với kiến trúc Transformer làm thay đổi cách máy móc hiểu và xử lý ngôn ngữ.

Mùa hè năm 2017, nhóm nghiên cứu từ Google Brain đã âm thầm công bố một báo cáo mang tên Attention Is All You Need. Dù không nhận được nhiều sự chú ý ngoài cộng đồng học thuật, báo cáo này đã đặt nền móng cho gần như mọi mô hình AI tạo sinh nổi bật hiện nay, từ GPT của OpenAI đến các biến thể LLaMA của Meta, BERT, và Claude.

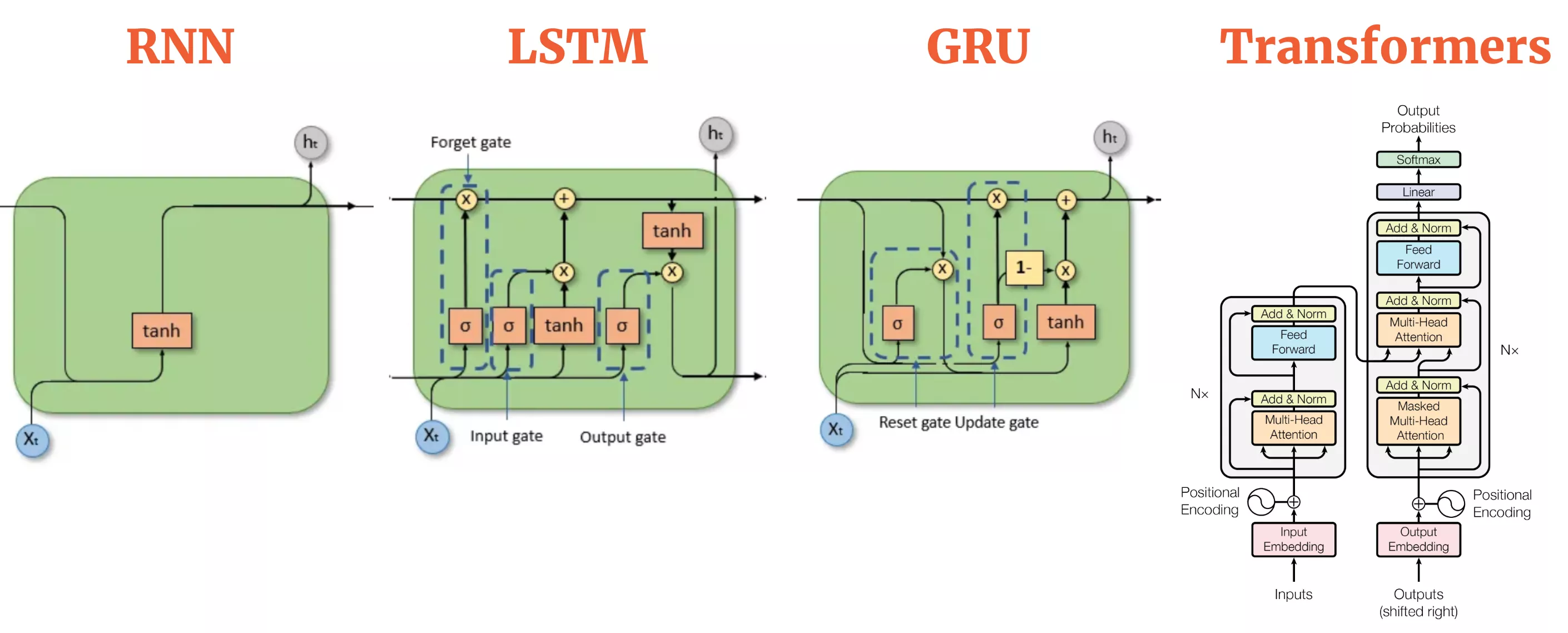

Kiến trúc Transformer, được giới thiệu trong báo cáo, là một bước ngoặt lớn cho xử lý ngôn ngữ tự nhiên (NLP). Khác với các mô hình hồi quy trước đó (như LSTM và GRU) vốn xử lý dữ liệu theo từng bước, Transformer dựa vào cơ chế “tự chú ý” (self-attention) để phân tích toàn bộ câu cùng một lúc, giúp cải thiện đáng kể khả năng hiểu ngữ cảnh. Điều này không chỉ nâng cao hiệu quả mà còn mở ra tiềm năng xử lý dữ liệu lớn với tốc độ nhanh hơn.

Trước Transformer, các mô hình NLP phải dựa vào mạng hồi quy để xử lý ngôn ngữ theo trình tự, từng từ một. Dù trực quan và phù hợp với cách con người đọc hiểu ngôn ngữ, cách tiếp cận này gặp nhiều hạn chế, đặc biệt là trong việc xử lý các câu dài và khó song song hóa. Transformer đã loại bỏ sự phụ thuộc vào hồi quy, thay vào đó sử dụng hoàn toàn cơ chế chú ý để xác định mối liên kết giữa các từ trong câu. Điều này giúp cải thiện khả năng xử lý ngữ cảnh, tăng tốc độ huấn luyện và giảm đáng kể chi phí tính toán.

Cơ chế tự chú ý nhanh chóng trở thành tâm điểm nghiên cứu. Nhờ vào cấu trúc song song hóa, Transformer vượt trội hơn hẳn so với các mô hình hồi quy trong các nhiệm vụ như dịch máy, phân tích ngữ nghĩa, và thậm chí sáng tạo nội dung. Chỉ trong vài năm, Transformer không chỉ thay đổi cách NLP hoạt động mà còn lan tỏa sang các lĩnh vực khác như xử lý hình ảnh, âm thanh và dữ liệu khoa học.

Google đã nhanh chóng phát triển kiến trúc này thành BERT (Bidirectional Encoder Representations from Transformers), một bước tiến lớn trong khả năng hiểu ngôn ngữ của máy tính. BERT nhanh chóng được tích hợp vào các sản phẩm như công cụ tìm kiếm của Google, giúp cải thiện cách truy vấn được phân tích. Song song đó, OpenAI đã biến đổi Transformer thành GPT, với trọng tâm là tạo sinh văn bản. GPT-3 và các phiên bản tiếp theo chứng minh khả năng tạo nội dung tự nhiên, mở rộng ứng dụng của AI từ dịch thuật đến viết mã.

Tuy nhiên, sự phát triển của Transformer không chỉ dừng lại ở NLP. Các ứng dụng như CLIP và DALL-E cho thấy khả năng kết hợp văn bản và hình ảnh một cách mượt mà. Trong khoa học, từ dự báo tài chính đến phân tích y sinh, các mô hình Transformer đã cho thấy giá trị của mình. Các nền tảng mã nguồn mở như TensorFlow và PyTorch cũng nhanh chóng tích hợp các công cụ hỗ trợ xây dựng Transformer, tạo điều kiện cho cả cá nhân lẫn doanh nghiệp nhỏ tham gia nghiên cứu và phát triển.

Sự gia tăng quy mô của các mô hình Transformer cũng đặt ra nhiều câu hỏi mới. Khi các mô hình ngày càng lớn, việc huấn luyện chúng tiêu tốn nguồn tài nguyên khổng lồ, từ chi phí tính toán đến năng lượng. Bên cạnh đó, những lo ngại về tính công bằng, thiên kiến, và bảo vệ dữ liệu ngày càng trở nên rõ rệt, đòi hỏi các chính sách quản lý chặt chẽ hơn.

Đến nay, báo cáo Attention Is All You Need không chỉ là minh chứng cho sức mạnh của nghiên cứu mở mà còn khẳng định giá trị của việc hợp tác trong cộng đồng AI. Tuy nhiên, câu hỏi lớn vẫn còn đó: liệu chú ý có thực sự là tất cả những gì chúng ta cần? Trong khi các kiến trúc mới như Longformer hay Reformer đang được nghiên cứu để xử lý tốt hơn các chuỗi dữ liệu dài, cộng đồng AI vẫn tiếp tục đẩy giới hạn của Transformer.

Đến nay, báo cáo Attention Is All You Need không chỉ là minh chứng cho sức mạnh của nghiên cứu mở mà còn khẳng định giá trị của việc hợp tác trong cộng đồng AI. Tuy nhiên, câu hỏi lớn vẫn còn đó: liệu chú ý có thực sự là tất cả những gì chúng ta cần? Trong khi các kiến trúc mới như Longformer hay Reformer đang được nghiên cứu để xử lý tốt hơn các chuỗi dữ liệu dài, cộng đồng AI vẫn tiếp tục đẩy giới hạn của Transformer.

Những tiến bộ này không chỉ mang lại cơ hội mà còn đặt ra thách thức mới, đặc biệt khi AI ngày càng ảnh hưởng sâu rộng đến mọi mặt đời sống.